イリヤがOpenAIを離れた内幕:ウルトラマンにチームの計算能力を削減され、製品開発を優先して利益を上げることに。退職の不満を言えば株式を失うことになる。

著者:量子位

連続で13件のツイート!

OpenAIのスーパーアライメント責任者Jan Leike、つまりIlyaに続いて会社を離れたばかりの彼が、退職の真の理由やその他の内幕を明かしました。

一つ目は計算能力が不足している、スーパーアライメントチームに約束された20%が足りず、チームは逆風にさらされ、ますます困難になっています。

二つ目は安全が軽視されている、AGIの安全管理問題に対する優先度が「輝かしい製品」を出すことよりも低いです。

続いて、他の人々によってさらなるゴシップが掘り起こされました。

例えば、OpenAIを退職するメンバーは全員、退職後にOpenAIの悪口を言わないことを保証する契約にサインする必要がある、サインしない場合は自動的に会社の株を放棄したと見なされます。

しかし、サインを拒否する頑固者もいて、核心的なリーダーシップの安全問題に対する優先度の違いは長年のものだと暴露しています(笑)。

昨年の宮廷闘争以来、二派の観念の対立は臨界点に達し、見た目はかなり体裁よく崩壊しました。

したがって、オルトマンが共同創業者を派遣してスーパーアライメントチームを引き継がせたにもかかわらず、外部からはあまり期待されていません。

最前線のTwitterユーザーたちは、Janがこの驚くべきスクープを語る勇気を持ったことに感謝し、感嘆しています:

「なんだこれは、OpenAIは本当に安全性をあまり重視していないようだ!」

しかし振り返ると、現在OpenAIを掌握しているオルトマンは、しばらくは落ち着いています。

彼はJanのOpenAIのスーパーアライメントと安全に対する貢献に感謝し、Janが去ることに対して非常に悲しいと述べています。

もちろん、実際のポイントはこの一文です:

「待っていて、数日後にこれよりも長いツイートを発表するつもりだ。」

約束された20%の計算能力には実際に大きな期待があった

昨年のOpenAIの宮廷闘争から現在まで、重要人物で前首席科学者のIlyaはほとんど公に姿を現さず、発言もしなくなりました。

彼が公に退職を宣言する前から、様々な憶測が飛び交っていました。多くの人がIlyaが人類を滅ぼす可能性のあるAIシステムを目撃したのではないかと考えています。

△ユーザー:私が毎朝目覚めて最初に考えることは、Ilyaが何を見たかです。

△ユーザー:私が毎朝目覚めて最初に考えることは、Ilyaが何を見たかです。

今回、Janは核心的な理由を明らかにしました。それは技術派と市場派が安全に関する優先順位について異なる見解を持っていることです。

対立は非常に深刻で、現在の結果は……皆さんも見ての通りです。

Voxの報道によれば、OpenAIに詳しい情報筋は、安全を重視する従業員がオルトマンに対する信頼を失っていると述べています。「これは信頼が少しずつ崩壊していくプロセスです」。

しかしご覧の通り、公の場やプラットフォームでは、退職した従業員がこの問題について公に語ることはあまりありません。

一部の理由は、OpenAIが常に従業員に非中傷契約を含む退職契約にサインさせる伝統を持っているためです。サインを拒否すると、以前に得たOpenAIのオプションを放棄することになります。これは、発言する従業員が巨額の損失を被る可能性があることを意味します。

しかし、ドミノ倒しのように次々と倒れていきました------

Ilyaの辞職はOpenAIの最近の退職ラッシュを加速させました。

続いて退職を発表したのは、スーパーアライメントチームの責任者Janの他に、少なくとも5人の安全チームのメンバーが退職しました。

その中には非中傷契約にサインしなかった頑固者、Daniel Kokotajlo(以下DK兄)もいます。

△昨年DK兄は、AIが生存の危機に直面する可能性を70%と考えていると述べました。

△昨年DK兄は、AIが生存の危機に直面する可能性を70%と考えていると述べました。

DK兄は2022年にOpenAIに参加し、ガバナンスチームで働き、主な仕事はOpenAIの安全なAIの展開を導くことでした。

しかし、彼も最近退職し、外部のインタビューに応じました:

OpenAIはより強力なAIシステムを訓練しており、最終的には人間の知能を完全に超えることを目指しています。

これは人類史上最も素晴らしい出来事かもしれませんが、もし私たちが慎重に行動しなければ、最悪の事態を招く可能性もあります。

DK兄は述べています。彼がOpenAIに参加した当初、安全なガバナンスに対する復讐と希望を抱いており、OpenAIがAGIに近づくほど責任を持つことを期待していました。しかし、チーム内の多くの人々が徐々にOpenAIはそうではなくなることに気づきました。

「次第にOpenAIのリーダーシップや彼らがAGIを責任を持って扱う能力に対する信頼を失っていった」、これがDK兄が辞職した理由です。

未来のAGI安全に対する失望は、Ilyaの辞職ラッシュの中で多くの人が去る一因となっています。

もう一つの理由は、スーパーアライメントチームが、外部が想像するほど資源豊富に研究を行えるわけではないということです。

たとえスーパーアライメントチームがフル稼働しても、チームはOpenAIが約束した20%の計算能力しか得られません。

さらに、チームのいくつかの要求はしばしば却下されます。

もちろん、計算リソースはAI企業にとって非常に重要であり、すべてを合理的に配分する必要があります。また、スーパーアライメントチームの仕事は「もし会社がAGIを成功裏に構築した場合、実際に発生するさまざまなタイプの安全問題を解決すること」です。

言い換えれば、スーパーアライメントチームはOpenAIが直面する未来の安全問題に対応しているのです------重要なのは、未来の、果たして発生するかどうかわからない問題です。

執筆時点で、オルトマンは「(Janの内幕暴露よりも)長いツイート」をまだ発表していません。

しかし、彼は簡単に言及しました。Janの安全問題に対する懸念は正しいとし、「私たちはまだ多くのことをしなければならない;私たちもそれに取り組んでいます。」

この点について、皆さんは小さな椅子を用意して待っていてください。その時に一緒に最初にスクープを楽しみましょう。

総じて、現在スーパーアライメントチームは多くの人が去り、特にIlyaとJanの退職は、この嵐の中のチームを無秩序な状態にしています。

今後の計画は、共同創業者のJohn Schulmanが引き継ぐことですが、もはや専任のチームは存在しません。

新しいスーパーアライメントチームは、より緩やかに連携する小グループとなり、メンバーは会社のさまざまな部門に分散し、OpenAIの広報担当者はこれを「より深く統合する」と表現しています。

この点も外部から疑問視されています。なぜなら、Johnの本来のフルタイムの仕事は、現在のOpenAI製品の安全問題を確保することだからです。

突然責任が増えた後、Johnが現在と未来の安全問題に関心を持つ二つのチームをうまくリードできるかどうかは不明です。

Ilya-オルトマンの争い

時間の軸を引き延ばすと、実際に今日の崩壊はOpenAIの「宮廷闘争」Ilya-オルトマンの争いの続編です。

時間を昨年11月に戻すと、その時Ilyaはまだ在籍しており、OpenAIの取締役会と協力してオルトマンを解雇しようとしました。

その時の理由は、彼がコミュニケーションにおいて誠実さに欠けているというものでした。言い換えれば、私たちは彼を信頼していない。

しかし、最終的な結果は明らかです。オルトマンは彼の「同盟者」と共にマイクロソフトに参加する脅威を持ち出し、取締役会は屈服し、解任の試みは失敗しました。Ilyaは取締役会を離れました。そしてオルトマンは、彼にとってより有利なメンバーを取締役会に加えました。

その後、Ilyaは社交プラットフォームから姿を消し、数日前に公式に退職を発表するまで、約6ヶ月間OpenAIのオフィスに現れなかったと言われています。

当時、彼は興味深いツイートを残しましたが、すぐに削除されました。

過去1ヶ月間、私は多くの教訓を学びました。その一つは、「士気が高まる前に、暴力は続く」という言葉が、思っている以上に頻繁に当てはまるということです。

しかし、内部の情報筋によれば、Ilyaは遠隔でスーパーアライメントチームを共同で指導していました。

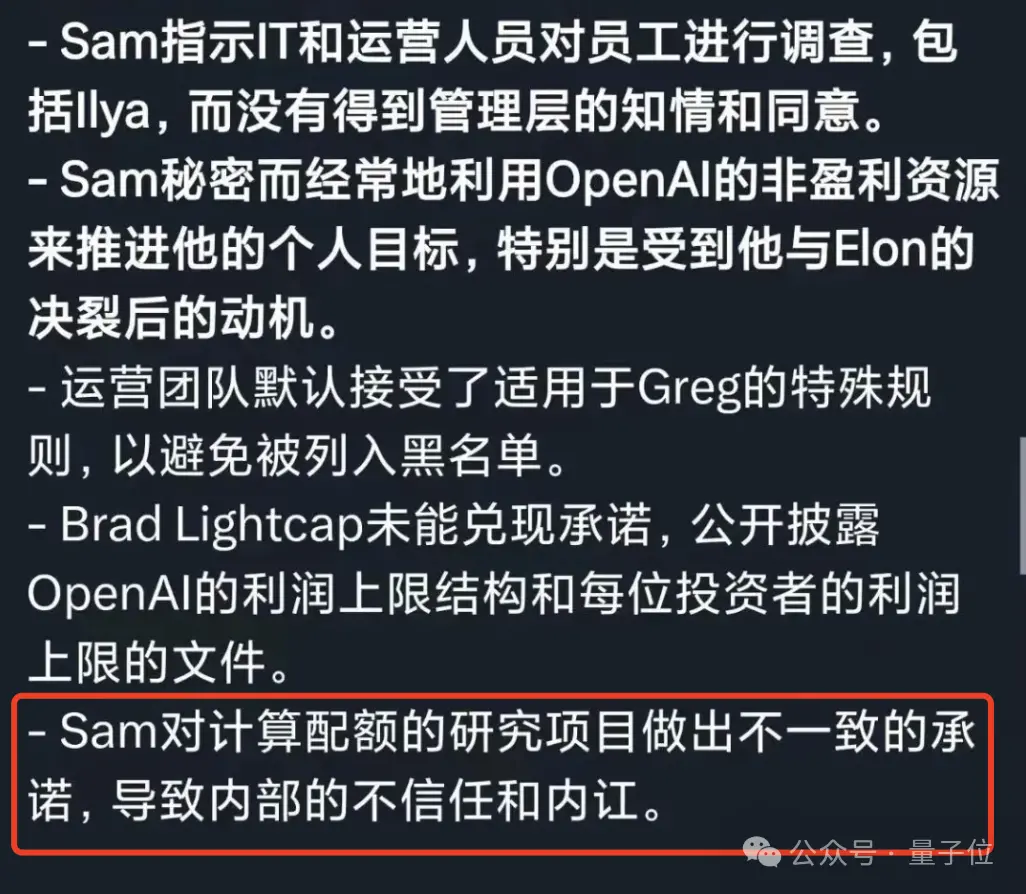

一方、オルトマンに対する従業員の最大の非難は、言行不一致です。彼は安全を優先したいと主張していますが、その行動は矛盾しています。

約束された計算リソースが提供されないだけでなく、最近ではサウジアラビアなどから資金を調達してチップを製造しようとしています。

安全を重視する従業員は困惑しています。

もし彼が本当にできるだけ安全な方法で人工知能を構築し、展開することを気にかけているのなら、技術の進展を加速するためにチップをこんなに急いで集めることはないでしょう?

さらに以前、OpenAIはオルトマンが投資したスタートアップからチップを5100万ドル(約3.6億元)で発注しました。

そして、宮廷闘争の数日間、OpenAIの元従業員の告発文では、オルトマンに関する記述が再び確認されているようです。

このように、始終「言行不一致」の行動が、従業員たちのOpenAIやオルトマンに対する信頼を徐々に失わせています。

Ilyaもそう、Jan Leikeもそう、スーパーアライメントチームもそうです。

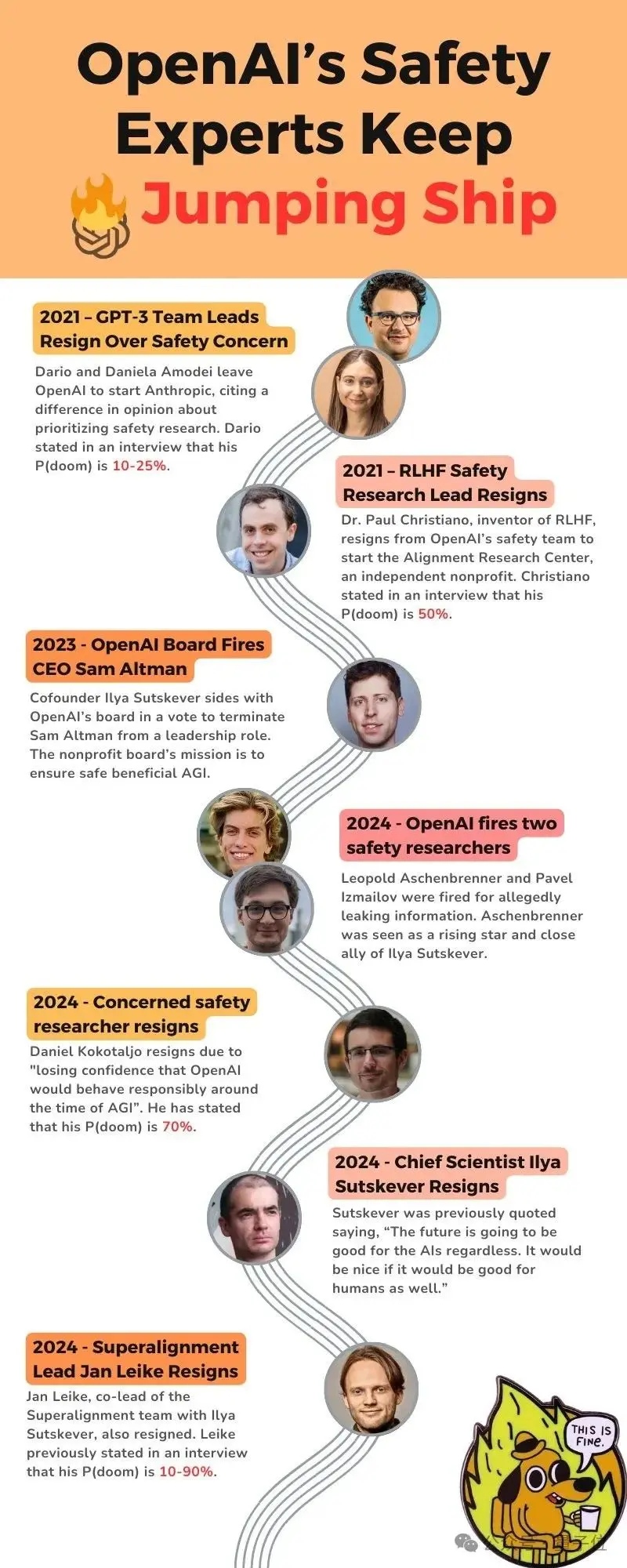

親切なユーザーがこの数年間に起こった関連する出来事の重要な節目を整理しました------まずは親切なヒントとして、以下に言及されるP(doom)は「AIが引き起こす世界の終わりのシナリオの可能性」を指します。

- 2021年、GPT-3チームの責任者が「安全」問題でOpenAIを退職し、Anthropicを設立;その中の一人はP(doom)を10-25%と考えていました;

- 2021年、RLHF安全研究責任者が退職、P(doom)は50%;

- 2023年、OpenAI取締役会がオルトマンを解雇;

- 2024年、OpenAIが2人の安全研究者を解雇;

- 2024年、安全に特に注目しているOpenAIの研究者が退職、彼はP(doom)が70%に達していると考えています;

- 2024年、IlyaとJan Leikeが退職。

技術派か市場派か?

大規模モデルの発展に至るまで、「AGIをどのように実現するか?」は実際に二つのルートに集約できます。

技術派は技術が成熟し制御可能になってから応用することを望み、市場派はオープンにしながら応用し「段階的」にゴールに到達することを考えています。

これがIlya-オルトマンの争いの根本的な対立であり、OpenAIの使命に関するものです:

AGIとスーパーアライメントに焦点を当てるのか、それともChatGPTサービスの拡大に焦点を当てるのか?

ChatGPTサービスの規模が大きくなるほど、必要な計算量も増えます;これによりAGI安全研究の時間が占有されます。

もしOpenAIが研究に専念する非営利団体であれば、彼らはスーパーアライメントにもっと多くの時間を費やすべきです。

しかし、OpenAIの対外的な施策を見る限り、結果は明らかにそうではありません。彼らは単に大規模モデルの競争で先頭に立ち、企業や消費者により多くのサービスを提供したいと考えています。

これをIlyaは非常に危険なことだと見なしています。私たちは規模が拡大することで何が起こるかは不明ですが、Ilyaにとって最善の方法は安全第一です。

オープンで透明であることで、私たち人類は安全にAGIを構築できることを確保できるのです。秘密の方法でではなく。

しかし、オルトマンの指導の下でのOpenAIは、オープンソースもスーパーアライメントも追求していないようです。逆に、AGIの方向に突き進みながら、同時に防御線を築こうとしています。

では、AI科学者Ilyaの選択が正しかったのか、それともシリコンバレーの商人オルトマンが最後まで行き着くのか?

今はまだわかりません。しかし少なくともOpenAIは現在、重要な選択に直面しています。

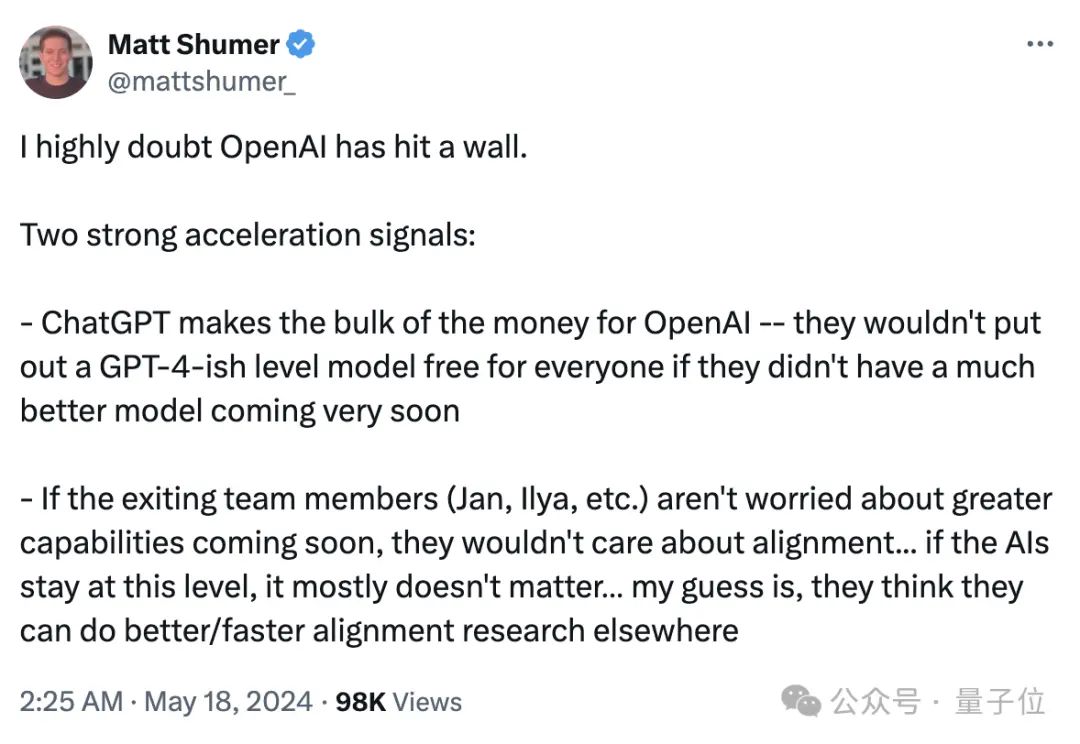

業界の専門家が二つの重要な信号をまとめました。

一つ目はChatGPTがOpenAIの主要な収入源であり、より良いモデルが支えなければ、GPT-4をすべての人に無料で提供することはないということ;

二つ目は、退職したチームメンバー(Jan、Ilyaなど)がすぐにより強力な機能が出現することを心配していなければ、彼らは整合性の問題を気にしないでしょう……もしAIがこのレベルに留まるなら、基本的にはどうでもいいことです。

しかし、OpenAIの根本的な矛盾は解決されていません。一方では、責任あるAGIの発展に対するAI科学者の懸念があり、もう一方ではシリコンバレーの市場派が商業化の方法で技術の持続可能性を推進することに急を要しています。

両者はもはや調和が取れず、科学派はOpenAIから完全に排除されており、外部もGPTが一体どの段階にあるのかを未だに知らないのです。

この問題の答えを切実に知りたい観衆は、少し疲れてきています。

無力感が心に押し寄せます。まるでIlyaの師匠であり、チューリング賞の三巨頭の一人であるヒントンが言ったように:

「私は年を取りました、心配していますが、無力です。」

参考リンク:

[1]https://www.vox.com/future-perfect/2024/5/17/24158403/openai-resignations-ai-safety-ilya-sutskever-jan-leike-artificial-intelligence

[2]https://x.com/janleike/status/1791498174659715494

[3]https://twitter.com/sama/status/1791543264090472660