对话 0G Labs:DA 终局之路和链上 AI 新纪元

编译:思维怪怪,BlockBeats

译者注:今年 3 月,0G Labs 完成 Hack VC 领投的 3500 万美元 Pre-Seed 轮融资。0G Labs 旨在构建第一个模块化 AI 链,帮助开发者在高性能、可编程的数据可用性层上推出 AI dApp。通过创新的系统设计,0G Labs 力争实现每秒 GB 级的链上数据传输,支持 AI 模型训练等高性能应用场景。

在 DealFlow 第四期播客节目中,BSCN 主编 Jonny Huang、MH Ventures 普通合伙人 Kamran Iqbal 和 Animoca Brands 投资与战略合作负责人 Mehdi Farooq 共同采访了 0G Labs 的联合创始人兼 CEO Michael Heinrich。Michael 分享了他的个人背景,从微软和 SAP 实验室的软件工程师到创办估值超 10 亿美元的 Web2 公司 Garten,再到如今全职投入 0G,致力于在区块链上构建模块化 AI 技术栈。讨论内容涵盖了 DA 的现状和愿景、模块化的优势、团队管理以及 Web3 与 AI 的双向依赖关系。展望未来,他强调 AI 将成为主流,带来巨大的社会变革,Web3 需要跟上这一趋势。

以下为访谈正文:

Web2 独角兽掌门再创业

Jonny :今天我们要深入探讨一个重要话题——数据可用性( DA ),特别是加密 AI 领域的数据可用性。 Michael ,你们公司在这一领域有很大的发言权。在深入细节之前,请你简单介绍一下职业背景,以及你是如何进入这一小众领域的。

Michael :我最初是微软和 SAP 实验室的软件工程师和技术产品经理,在 Visual Studio 团队从事前沿技术工作。后来转向业务端,在贝恩公司工作了几年,又搬到康涅狄格州为桥水基金工作,负责投资组合构建。每天要审核约 600 亿美元的交易,了解很多风险指标。比如,我们查看 CDS 利率来评估交易对手风险等。这段经历让我深入了解了传统金融。

之后,我回到斯坦福读研,创办了我的第一家 Web2 公司 Garten 。公司鼎盛时期员工一度扩展到 650 名,年收入达 1 亿美元,总融资额约 1.3 亿美元,成为估值超 10 亿美元的独角兽公司和 Y Combinator 孵化的明星项目。

2022 年底,我在斯坦福的同学 Thomas 联系我。他提到五年前投资了 Conflux ,认为 Ming Wu 和 Fan Long 是他资助过的最优秀的工程师,我们四个应该聚在一起,看看能不能碰撞出什么火花。经过六个月的相处,我得出同样的结论。我心想:「哇, Ming 和 Fan 是我合作过的最优秀的工程师和计算机科学家。我们一定要一起创业。」我开始转为 Garten 的董事长,并且全职投入 0G 。

0G Labs 的四位联合创始人,从左至右分别为 Fan Long、Thomas Yao、Michael Heinrich、Ming Wu

DA 的现状、挑战与终极目标

Jonny :这是我听过的最棒的创始人介绍之一,我猜你们的 VC 融资过程一定很顺利。在深入探讨数据可用性这个话题之前,我想先讨论一下 DA 的现状。虽然有一些玩家众所周知,但就目前而言,你如何评估 DA 的格局?

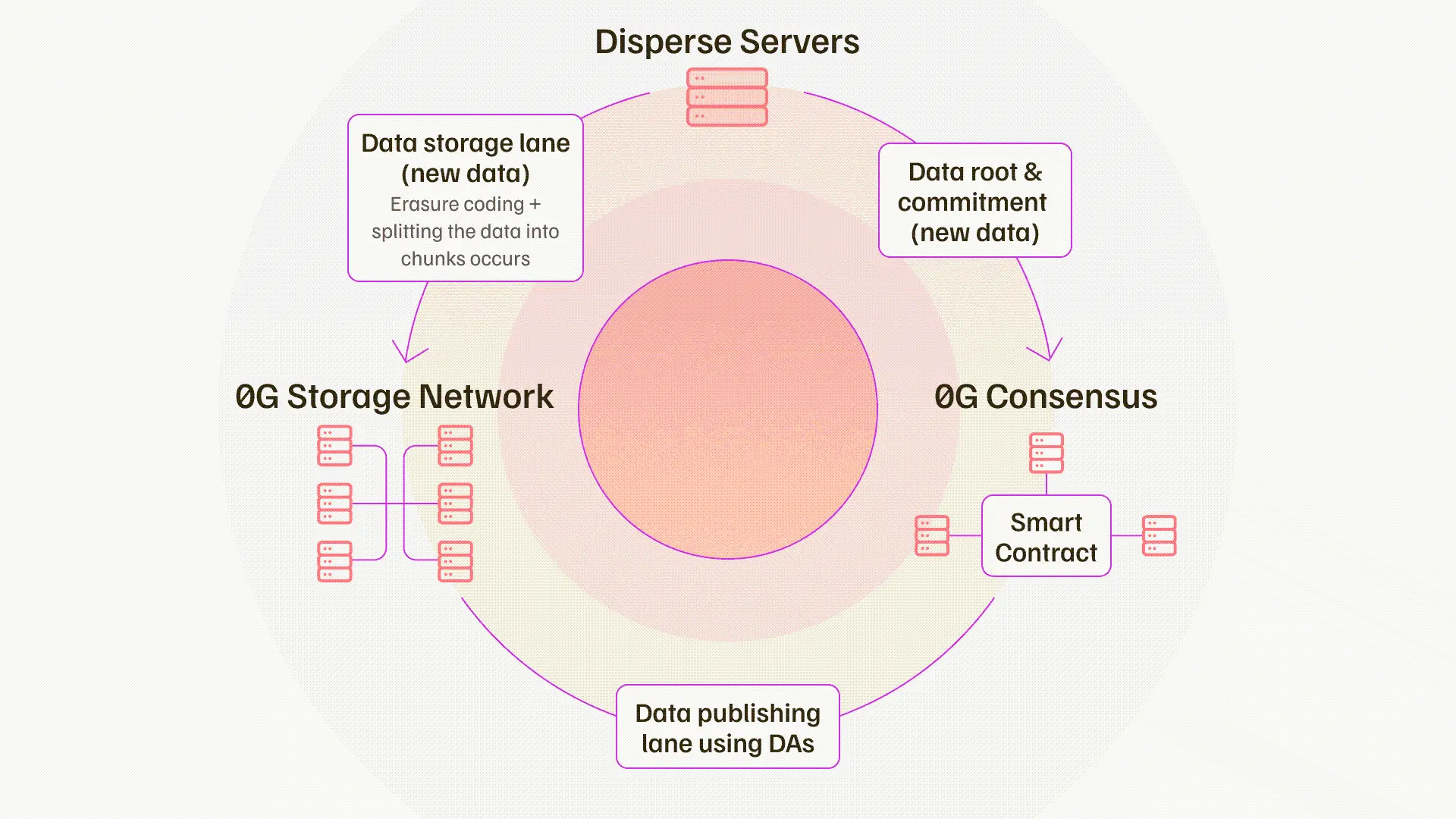

Michael :DA 现在有多种来源,具体取决于区块链。例如,在以太坊 Danksharding 升级之前,以太坊的 DA 大约为每秒 0.08 MB。后来,Celestia、EigenDA 和 Avail 进入市场,它们的吞吐量通常在每秒 1.2 到 10 MB 之间。问题在于,对于 AI 应用或任何链上游戏应用,这种吞吐量远远不够。我们需要讨论的是每秒 GB 级,而不是每秒 MB 级的 DA。举个例子,如果你想在链上训练 AI 模型,实际上需要每秒 50 到 100 GB 的数据传输量才能实现。这是数量级的差异。我们看到了这个机会,思考如何创造这种突破,使 Web2 的大型应用程序能够以相同的性能和成本在链上构建。这是我们在该领域看到的一个巨大空白。此外,还有一些问题没有得到充分考虑。比如,我们认为数据可用性是数据发布和数据存储的结合。我们的核心洞察是将数据分成这两个通道来避免系统中的广播瓶颈,从而实现突破性的性能改进。

一个附加的存储网络可以让你做很多事情,比如模型存储、针对特定用例的训练数据存储,甚至可编程性。你可以进行完整的状态管理,决定将数据存储在哪里,存储多长时间,以及需要多少安全性。因此,各种领域真正需要的真实用例,现在都成为可能。

目前 DA 的现状是,我们取得了重大进展,从每秒 0.08 MB 提高到 1.4 MB ,确实降低了交易成本,在某些情况下甚至减少了 99%。但对于未来世界的真正需求来说,这还不够。高性能 AI 应用、链上游戏、高频 DeFi ,所有这些应用都需要更高的吞吐量。

Mehdi :我有两个基础性的问题。首先是关于存储。你提到 L2 的交易历史,甚至是 AI 模型的历史。在存储方面,我们需要存储数据多长时间?这是我的第一个问题。第二个问题是,已经有 Arweave 和 Filecoin 这样的去中心化存储网络,你认为它们能否帮助提高吞吐量?我指的不是数据发布,而是存储。

Michael :数据的存储时长取决于其目的。如果考虑灾难恢复,数据应永久存储,以便重构状态。对于乐观 rollup 那种有欺诈证明窗口的情况,至少需要存储 7 天,以便在需要时重构状态。对于其他类型的 rollup,存储时间可能更短。具体情况不同,但大致如此。

至于其他存储平台,我们选择内部构建存储系统,因为 Arweave 和 Filecoin 更多是为日志类型的存储而设计的,也就是长期冷存储。因此它们并非为非常快速的数据写入和读取而设计,而这对 AI 应用以及需要键值存储或事务型数据类型的结构化数据应用至关重要。这样才能实现快速处理,甚至可以搭建去中心化的 Google 文档应用。

Jonny :关于为什么需要 DA ,以及现有的去中心化存储解决方案为何不适合这种特定场景,你阐述得非常清楚。可以讨论一下数据可用性的终极目标吗?

Michael :终极目标很容易定义,我们要实现的是与 Web2 相当的性能和成本,使得在链上构建任何东西都成为可能,特别是 AI 应用。这很直白,就像 AWS 有计算和存储,S3 是一个关键组件。数据可用性虽然有不同特性,但也是一个关键组件。我们的最终目标是构建一个模块化的 AI 技术栈,其中的数据可用性部分不仅包括数据发布,还包括存储组件,由共识网络整合。我们让共识网络处理数据可用性抽样,一旦达成共识,我们就能在底层 Layer 1(如以太坊)上进行证明。我们的最终目标是构建一个可以运行任何高性能应用的链上系统,甚至支持链上训练 AI 模型。

Kamran :能再详细说明一下你们的目标市场吗?除了人工智能和那些在区块链上构建 AI 应用的人之外,你们希望哪些项目使用 0G ?

Michael :你已经提到一个应用领域。我们正努力建设最大的去中心化 AI 社区,并希望有大量项目在我们之上构建。无论是 Pond 在构建大型图模型,还是 Fraction AI 或 PublicAI 在做去中心化数据标注或清洗,甚至是 Allora、Talus Network 或 Ritual 这样的执行层项目,我们都在努力为 AI 建设者建立最大的社区。这对我们来说是基本要求。

但实际上,任何高性能应用都可以在我们之上构建。以链上游戏为例,5000 个用户在非压缩情况下,需要每秒 16MB 的数据可用性来实现完整的链上游戏状态。目前没有任何 DA 层能做到这一点,也许 Solana 可以,但那与以太坊生态系统不同,支持也有限。所以,这样的应用对我们来说也非常有趣,特别是如果它们结合了链上 AI 代理(如 NPC )。在这方面有很多交叉应用的潜力。

高频 DeFi 是另一个例子。未来的全同态加密 ( FHE )、数据市场、高频深端应用,所有这些都需要非常大的数据吞吐量,需要一个能够真正支持高性能的 DA 层。因此,任何高性能的 DA pp 或 Layer2 都可以在我们之上构建。

模块化的优势:灵活选择

Mehdi :你们在努力提高可扩展性、吞吐量,以及解决存储组件导致的状态膨胀问题。为什么不直接推出一条完整的 Layer1 呢?如果你们有能力在技术上取得突破,为什么要采用模块化的方法,而不是创建一个拥有自己虚拟机的 Layer1 呢?采用模块化堆栈背后的逻辑是什么?

Michael :从根本上说,我们底层就是一个 Layer1,但我们坚信模块化是未来构建应用的方式。而且我们是模块化的,并不排除未来提供一个专门针对 AI 应用优化的执行环境。我们还没完全确定这方面的路线图,但这是可能的。

模块化的核心在于选择。你可以选择结算层、执行环境和 DA 层。根据不同的用例,开发者可以选择最佳方案。就像 Web2 中, TCP / IP 之所以成功,是因为它本质上是模块化的,开发者可以自由选择使用其不同方面。因此,我们希望给予开发者更多选择,让他们根据自己的应用类型,构建最合适的环境。

Mehdi :如果现在要选择一个虚拟机,就你们正在考虑或努力实现的应用而言,市场上哪个虚拟机最适合?

Michael :我对此持非常实际的看法。如果为了吸引更多 Web2 开发者进入 Web3,那应该是某种类型的 WASM 虚拟机,可以用最常见的编程语言如 JavaScript 或 Python 来构建应用。这些语言不一定是链上开发的最佳选择。

Move VM 在对象和吞吐量方面的设计非常出色。如果追求高性能,这是一个值得关注的选择。如果考虑经过实战检验的虚拟机,那就是 E VM ,因为有大量的 Solidity 开发者。所以选择取决于具体的使用场景。

优先级排序和社区建设

Jonny :我想听听你们面临的最大障碍是什么,还是说一切都一帆风顺?我无法想象你们的事业如此庞大,不可能一直都那么顺利吧。

Michael :是的,我认为任何创业公司都不会一帆风顺,总会有一些挑战。从我的角度来看,最大的挑战是确保我们能跟上节奏,因为我们必须非常出色地执行多个任务,不得不做出一些权衡以快速进入市场。

例如,我们本来想用定制的共识机制启动,但那会延长四到五个月的启动时间。所以我们决定在第一阶段使用现成的共识机制,做一个强大的概念验证,达到终局目标的一部分,比如每个共识层每秒 50 GB 。然后在第二阶段引入可横向扩展的共识层,以实现无限的 DA 吞吐量。就像打开开关启动另一台 AWS 服务器一样,我们可以添加额外的共识层,从而提高整体 DA 吞吐量。

另一个挑战是确保我们能吸引到一流的人才加入公司。我们的团队实力雄厚,包括信息学奥林匹克竞赛金牌得主和顶尖的计算机科学博士,所以我们需要市场营销团队和新加入的开发人员也能与之匹配。

Jonny :听起来你们目前面临的最大障碍是优先级排序,对吧?接受无法在短时间内做所有事情,必须做出一些权衡。关于竞争,你们如何看待?我猜 Celestia 或 EigenDA 对你们的具体用例不会构成严重威胁。

Michael :在 Web3 中,竞争很大程度上取决于社区。我们围绕高性能和 AI 建设者建立了一个强大的社区,而 Celestia 和 EigenDA 可能拥有更多的通用型社区。EigenDA 可能更关心如何带来经济安全并在 EigenLayer 上构建 AVS,而 Celestia 则更关心哪个 Layer2 想要降低他们的交易成本,并且没有很多高吞吐量的应用。举个例子,在 Celestia 上构建高频 DeFi 非常具有挑战性,因为你需要每秒多兆字节的吞吐量,这会完全堵塞 Celestia 网络。

从这个角度来看,我们确实感受不到威胁。我们正在建立一个非常强大的社区,即使有其他人出现,我们也已经拥有开发者和市场份额的网络效应,并有望随之获得更多资金。所以,最好的防御就是我们的网络效应。

Web3 与 AI 的双向依赖

Jonny :你们选择人工智能作为主要发力点,但为什么 Web3 需要在其生态系统内托管人工智能?反过来,人工智能为什么需要 Web3 ?这是一个双向的问题,两个问题的答案不一定都是肯定的。

Michael :当然,没有 AI 的 Web3 是可能的。但我认为在未来 5 到 10 年里,每家公司都会成为 AI 公司,因为 AI 将像互联网那样带来巨大的变革。我们真的想在 Web3 中错失这个机会吗?我认为不会。根据麦肯锡的说法,AI 将释放数万亿美元的经济价值,70% 的工作可以由 AI 自动化。那么为什么不利用它呢?没有 AI 的 Web3 是可能存在的,但有了 AI,未来会更加美好。我们相信未来 5 到 10 年,区块链上的大多数参与者将是 AI 代理,他们为你执行任务和交易。这将是一个非常令人兴奋的世界,我们将拥有大量由 AI 驱动、为用户量身定制的自动化服务。

反过来,我认为 AI 也绝对需要 Web3 。我们的使命是让 AI 成为一种公共产品。这从根本上说是一个激励机制的问题。你如何确保 AI 模型不会作弊,如何确保它们做出最有利于人类的决策?对齐可以分解为激励、验证和安全组件,每一个组件都非常适合在区块链环境中实现。区块链可以通过代币来帮助实现金融化和激励,从而创造一个环境让 AI 在经济上不愿意作弊。所有交易历史也都在区块链上。这里做一个大胆的声明,我认为从根本上说,从训练数据到数据清洗组件,再到数据摄取和收集组件,所有东西都应该在链上,从而可以完整地追溯是谁提供了数据,然后 AI 模型又做出了什么决策。

展望未来 5 到 10 年,如果 AI 系统在管理后勤、行政和制造系统,我会想知道模型的版本、它的决策,并对超越人类智能的模型进行监督,确保它与人类利益实现对齐。而把 AI 装进一个可能作弊、不为人类最大利益做决策的黑匣子里,我不确定我们是否能信任几家公司始终如一地确保这种系统的安全和诚信,尤其是考虑到 AI 模型在未来 5 到 10 年可能具有的超级能力。

Kamran :我们都知道加密领域充满了各种叙事,而你们如此专注于 AI 领域,从长远来看,你认为这会成为你们的障碍吗?正如你所说,你们的技术栈将远优于我们现在所见到的。你认为围绕 AI 的叙事和命名本身,会在未来阻碍你们的发展吗?

Michael :我们不这么认为。我们坚信在未来,每家公司都将成为一家 AI 公司。几乎不会有哪家公司在其应用或平台中不以某种形式使用 AI。从这个角度来看,每当 GPT 推出一个新版本,比如拥有万亿级参数,开启了之前所不具备的新功能,达到了更高的性能水平。我认为热度将持续存在,因为这是一个全新的范式。这是我们首次能够用人类语言告诉计算机要做什么。在某些情况下,你可以获得超越普通人的能力,实现此前无法实现的流程自动化。例如,一些公司几乎完全自动化了他们的销售开发和客户支持。随着 GPT-5、GPT-6 等的发布,AI 模型将变得更加智能。我们需要确保在 Web3 中跟上这一趋势,构建我们自己的开源版本。

AI 代理将在未来运行社会的某些部分,确保其以适当的方式被区块链所治理至关重要。10 到 20 年内, AI 肯定会是主流,带来巨大的社会变革。看看特斯拉的全自动驾驶模式就知道了,未来正在一天天变成现实。机器人也会进入我们的生活,为我们提供大量支持。我们基本上正生活在一部科幻电影中。